2018 pourrait être l'année où les États-Unis reprendront l'avantage sur la Chine grâce au superordinateur le plus puissant du monde. Ce pourrait être l'année où la guerre de la puissance de calcul de l'IA a commencé.

2017 est l'année où l'Intelligence Artificielle a commencé à créer l'Intelligence Artificielle (IA). C'est l'année où la Chine a dépassé les États-Unis en termes de nombre total de supercalculateurs classés et de performance de calcul globale.

Tous ces événements façonnent profondément notre avenir ... et notre présent. Ils remanient la façon dont les guerres seront et sont déjà menées, tandis que la stratégie et, en fait, la portée de la sécurité nationale, s'étendent considérablement. Ils sont intimement liés. Il est essentiel de comprendre pourquoi et comment pour prévoir ce qui va probablement se passer et ce qui se passe déjà, et pour comprendre à quoi ressemblera le monde émergent de l'IA.

Cet article et les suivants, à l'aide d'exemples et de cas concrets, expliqueront comment et pourquoi l'IA et la puissance de calcul sont liées. Ils se concentreront donc sur le matériel et la puissance de calcul en tant que moteur, force et enjeu pour le développement de l'IA, dans le sous-domaine de l'IA de l'apprentissage approfondi (DL). Auparavant, nous avons identifié la puissance de calcul comme l'un des six moteurs qui non seulement agissent comme des forces derrière l'expansion de l'IA mais aussi, en tant que tels, deviennent des enjeux dans la compétition entre les acteurs dans la course à la puissance de l'IA (Hélène Lavoix, "Intelligence artificielle - forces, moteurs et enjeux". The Red Team Analysis Society26 mars 2018). Nous avons examiné en détail le premier conducteur avec "Les grandes données, moteur de l'intelligence artificielle... mais pas dans le futur ?" (Hélène Lavoix, The Red Team Analysis Society16 avril 2018)

Nous commencerons ici par les cas les plus récents - et les plus frappants - illustrant la relation étroite qui existe entre le matériel et sa puissance de calcul et le développement exponentiel actuel de l'IA, ou plus exactement l'expansion de DL. La puissance de calcul et l'AI-DL évoluent en fait conjointement. Nous présentons deux cas d'AI-DL créant des architectures de réseaux de neurones, donc DL : le projet AutoML de Google, ainsi que son impact par exemple en termes d'applications de vision par ordinateur, et le MENNDL (Multinode Evolutionary Neural Networks for Deep Learning) de l'Oak Ridge National Laboratory (ORNL) du ministère américain de l'énergie, et nous les mettons en relation avec la puissance de calcul nécessaire. Nous commençons ainsi à identifier les éléments cruciaux de la puissance de calcul nécessaire pour l'AI-DL, nous soulignons le potentiel des algorithmes évolutifs, et nous signalons que nous pourrions maintenant nous rapprocher d'une intelligence générale artificielle.

Nous approfondirons cette coévolution avec les prochains articles, afin de mieux comprendre comment et pourquoi la DL et la puissance de calcul/le matériel informatique sont liés. Nous examinerons plus en détail l'impact de cette relation et de sa coévolution en termes de matériel. Nous présenterons donc l'état des lieux de l'évolution rapide et identifierons les autres domaines qui doivent être surveillés. En attendant, nous expliquerons autant que possible le jargon technique des TFLOPS aux CPU, NPU ou TPU, qui n'est pas immédiatement compréhensible pour les scientifiques et spécialistes non AI et non TI, et qui doit pourtant être compris par les analystes politiques et géopolitiques et les personnes concernées. Cette plongée en profondeur nous permettra de mieux comprendre la dynamique correspondante qui émerge du nouveau monde de l'IA qui est en train de se créer.

En effet, nous expliquerons comment l'interdiction américaine de sept ans de la société de télécommunications chinoise ZTE et d'autres actions américaines connexes doivent être comprises comme une manœuvre stratégique dans ce qui fait partie de la course à la puissance IA - c'est-à-dire la course au statut de puissance relative dans la nouvelle répartition internationale du pouvoir en devenir - et ressemble de plus en plus à la première bataille d'une guerre pour la suprématie IA, comme le suggèrent les actions de resserrement des États-Unis contre les Huawei chinois (par exemple Li Tao, Celia Chen, Bien Perez, "La ZTE est peut-être trop grande pour échouer, car elle reste le dernier maillon de la chaîne de l'ambition technologique mondiale de la Chine“, SCMP21 avril 2018 ; Koh Gui Qing, "Exclusif - Les États-Unis envisagent de resserrer l'étau sur les liens entre la Chine et les entreprises américaines“, Reuters, 27 avril 2018).

Comme nous l'avions prévu, AI a déjà commencé à redessiner la géopolitique et le monde international (voir "Intelligence artificielle et apprentissage approfondi - Le nouveau monde de l'IA en devenir". et "Quand l'intelligence artificielle va alimenter la géopolitique - Présentation de l'IA".).

Commencer à envisager que l'IA crée des IA

AutoML de Google, la naissance de NASNet et d'AmoebaNets

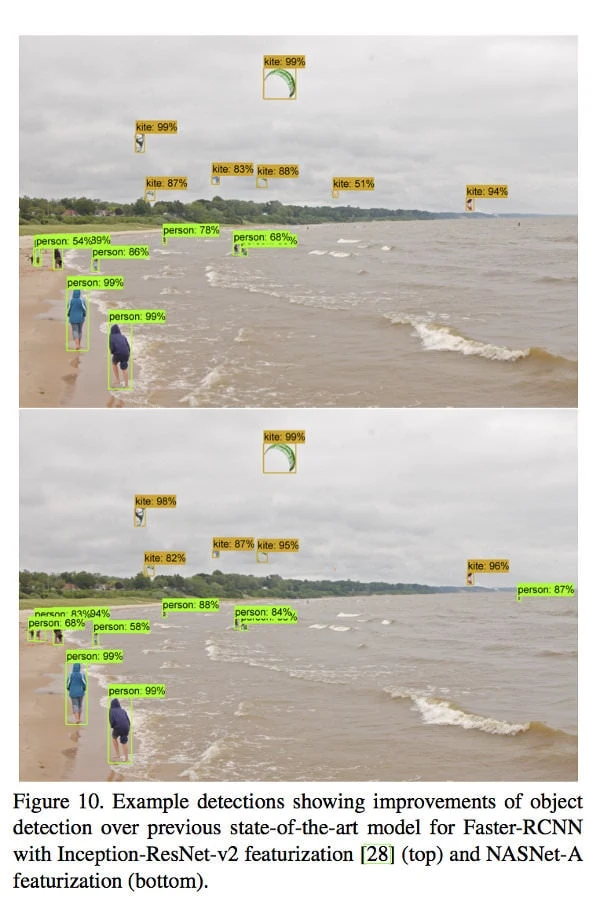

En mai 2017, Google Brain Team - un des laboratoires de recherche de Google - a annoncé le lancement d'une "approche" appelée AutoML qui vise à "explorer les moyens d'automatiser la conception de modèles d'apprentissage automatique", en utilisant notamment des algorithmes évolutifs et des algorithmes de Reinforcement Learning (RL), c'est-à-dire un aspect de la DL et donc de l'AI (Quoc Le & Barret Zoph, "Utiliser l'apprentissage machine pour explorer l'architecture des réseaux neuronaux“, Blog de recherche Google17 mai 2017). Ils ont d'abord appliqué avec succès l'approche pour la reconnaissance d'images et la modélisation du langage, mais avec de petits ensembles de données : "notre approche permet de concevoir des modèles dont la précision est comparable à celle des modèles de pointe conçus par des experts en apprentissage automatique (dont certains font partie de notre propre équipe !)". (Ibid.) Ensuite, ils ont testé AutoML pour de grands ensembles de données "tels que ImageNet classification des images et détection des objets COCO" (Barret Zoph, Vijay Vasudevan, Jonathon Shlens et Quoc Le, "AutoML pour la classification des images à grande échelle et la détection d'objets, Blog de recherche Google2 novembre 2017). C'est ainsi qu'est né le NASNet, de différentes tailles, qui, pour la reconnaissance d'images, a atteint une plus grande précision et des coûts de calcul inférieurs à ceux des autres architectures (voir la figure de Google sur la droite). Par exemple, "Le grand NASNet atteint une précision de pointe tout en réduisant de moitié le coût de calcul du meilleur résultat publié sur arxiv.org (c'est-à-dire SENet)". Les résultats pour la détection d'objets étaient également meilleurs que pour d'autres architectures (Ibid.).

Comme le soulignent les scientifiques de Google, le NASNet pourrait ainsi améliorer considérablement les applications de vision par ordinateur (Ibid.). Compte tenu de l'importance de la vision par ordinateur pour la robotique en général, pour le système d'arme autonome létale (LAWS) en particulier, il pourrait devenir crucial de pouvoir utiliser les types d'architecture du NASNet et du NASNet, et plus encore de créer de meilleurs programmes. Google "open-sourced NASNet for inference on image classification and for object detection" (Ibid.), qui devrait limiter - à un point considérant la nécessité d'utiliser également la plateforme de Google TensorFlow ainsi que le début de la guerre entre les États-Unis et la Chine au sujet de l'IA (à venir) - l'utilisation possible du NASNet par un acteur et non par un autre. Cet exemple montre que la capacité à développer et à faire fonctionner une "IA qui crée l'IA", qui est meilleure que les architectures d'IA conçues par l'homme, peut s'avérer cruciale pour la course à la puissance de l'IA, y compris en termes de guerre future possible, ainsi que pour la gouvernance de l'IA.

Un GPU est une unité de traitement graphique. Il a été lancé en tant que tel par NVIDIA en 1999 et est considéré comme le composant crucial qui a permis le décollage de DL.

Une unité centrale de traitement est une unité centrale de traitement. C'était la norme notamment avant l'avènement des GPU et l'expansion de DL-AI.

Les deux microprocesseurs sont construits avec des architectures différentes ayant des objectifs et des fonctions différents, par exemple Kevin Krewell, "Quelle est la différence entre un CPU et un GPU ? Blog de NVIDIA, 2009.

Si les architectures d'IA résultantes ont un "coût de calcul" inférieur à celui des architectures conçues par l'homme, quelle est la puissance de calcul nécessaire pour créer l'IA ? Selon les scientifiques de Google, "la recherche d'architecture initiale [utilisée pour AutoML] a utilisé 800 GPU pendant 28 jours, ce qui a donné 22 400 GPU-heures. La méthode présentée dans ce document [NASNet] utilise 500 GPU sur 4 jours, ce qui donne 2 000 heures de calcul. La première méthode utilisée NVIDIA K40 Les GPU, alors que les efforts actuels ont été utilisés plus rapidement NVIDIA P100s. Si l'on ne tient pas compte du fait que nous utilisons du matériel plus rapide, nous estimons que la procédure actuelle est environ 7 fois plus efficace (Barret Zoph, Vijay Vasudevan, Jonathon Shlens, Quoc V. Le, "Apprendre les architectures transférables pour la reconnaissance d'images à l'échelle", Soumis le 21 juillet 2017 (v1), dernière révision le 11 avril 2018 (cette version, v4), arXiv:1707.07012v4 [cs.CV] ).

La Google Brain Team poursuit ses efforts AutoML pour trouver la meilleure façon de développer des IA qui créent des IA. D'une expérience visant à comparer les mérites relatifs de l'utilisation de la RL et de l'évolution pour la recherche d'architecture afin de découvrir automatiquement des classificateurs d'images sont nés des algorithmes évolutifs AmoebaNets : "C'est la première fois que des algorithmes évolutionnaires produisent des classificateurs d'images de pointe" (Esteban Real, Alok Aggarwal, Yanping Huang, Quoc V Le, "Évolution régularisée pour la recherche d'architecture de classificateur d'images", soumis le 5 février 2018 (v1), dernière révision le 1er mars 2018 (cette version, v3) arXiv:1802.01548v3 [cs.NE]).

Un TPU est une unité de traitement des tenseurs, le circuit intégré spécifique à l'application créé par Google à des fins d'IA et lancé en mai 2016

Cependant, comme le soulignent les scientifiques, "toutes ces expériences ont nécessité beaucoup de calculs - nous avons utilisé des centaines de GPU/TPU pendant des jours". (Esteban Real, "Utiliser l'AutoML évolutif pour découvrir les architectures de réseaux de neurones“, Blog de recherche Google15 mars 2018). L'expérience d'évolution dédiée "a fonctionné avec 900 puces TPUv2 pendant 5 jours et a formé 27 000 modèles au total", tandis que chaque expérience à grande échelle "a fonctionné avec 450 GPU pendant environ 7 jours" (Real et al, Ibid., pp 12 & 3).

La puissance de calcul est donc cruciale dans cette nouvelle recherche de systèmes DL créant d'autres systèmes DL ou de systèmes AI créant des IA. Si le résultat obtenu peut ensuite réduire le coût de calcul, c'est uniquement parce qu'au départ, un matériel puissant était disponible. Pourtant, quelle que soit la puissance de calcul de Google dédiée à AutoML, elle n'est pas - encore ? - à la hauteur de ce qui pourrait se passer avec les supercalculateurs.

Un créateur d'IA rapide ... mais seulement avec un supercalculateur

MENNDL - Réseaux neuronaux évolutionnaires multinœuds pour l'apprentissage profond

Le 28 novembre 2017, des scientifiques de l'Oak Ridge National Laboratory (ORNL) du ministère américain de l'énergie ont annoncé qu'ils avaient développé un algorithme évolutif "capable de générer des réseaux neuronaux personnalisés" - c'est-à-dire des systèmes d'intelligence artificielle (IA) sous sa forme "Deep Learning" - "qui égalent ou dépassent les performances des systèmes d'intelligence artificielle artisanaux" pour l'application de l'IA à des problèmes scientifiques (Jonathan Hines pour ORNL, "La science à l'échelle de l'apprentissage profond"(ORNL, 28 novembre 2017). Ces nouveaux systèmes d'IA sont produits en quelques heures et non en quelques mois comme si des êtres humains les fabriquaient (Ibid.), ou en quelques jours et semaines comme ce que Google a réalisé.

FLOPS signifie Floating Point Operations Per Second.

Il s'agit d'une mesure de la performance des ordinateurs.Un téraFLOPS (TFLOPS) représente un million de millions (1012) des opérations en virgule flottante par seconde.

Un pétaFLOPS (PFLOPS) représente 1000 téraFLOPS (TFLOPS).

Toutefois, cet exploit n'est possible que parce que MENNDL (Multinode Evolutionary Neural Networks for Deep Learning) - l'algorithme évolutif qui "est conçu pour évaluer, faire évoluer et optimiser les réseaux neuronaux pour des ensembles de données uniques" - est utilisé sur l'ordinateur Titan de l'ORNL, un système Cray XK7. Ce supercalculateur était le plus puissant au monde en 2012 (Liste du Top500, novembre 2017). En novembre 2017, il était "seulement" numéro cinq, mais restait le plus grand ordinateur des États-Unis (Ibid.) : "Ses 17,59 pétaflops sont principalement le résultat de ses accélérateurs GPU NVIDIA K20x" (Ibid.)

Désormais, l'ORNL devrait se doter d'un nouveau supercalculateur, qui devrait être mis en ligne fin 2018, Summit, un "supercalculateur IBM AC922 de 200 pétaflops" (Katie Elyce Jones "Les visages du sommet : Préparer le lancementORNL, 1er mai 2018). "Le sommet permettra de multiplier par plus de cinq [cinq à dix] les performances de calcul des 18 688 nœuds de Titan, en utilisant seulement environ 4 600 nœuds lorsqu'il arrivera en 2018". (Sommet et FAQ sur le sommet). Chaque nœud du Sommet est notamment constitué "de deux CPU IBM Power9, de six GPU NVIDIA V100" (FAQ sur le sommet). Cela signifie que nous disposons ici de la puissance de calcul de 9200 CPU IBM Power9 et de 27600 GPU NVIDIA V100. À titre de comparaison, Titan dispose de 299 008 cœurs de CPU Opteron et de 18 688 GPU K20X Keplers, soit 16 CPU et 1 GPU par nœud (TitanORNL) .

En comparaison, l'ordinateur le plus puissant de Chine - et du monde - ".Sunway TaihuLightun système développé par le Centre national chinois de recherche en ingénierie et technologie informatique parallèle (NRCPC), et installé au Centre national de superinformatique de Wuxi", offre une performance de 93,01 pétaflops (Liste du Top500, novembre 2017). Il utilise 10 649 600 cœurs de CPU Shenwei-64 (Jack Dongarra, "Rapport sur le système Sunway TaihuLight", www.netlib.orgLe Conseil de l'Union européenne a adopté une résolution sur le sujet en juin 2016 : 14).

En termes d'énergie, "Titan a démontré une consommation instantanée typique d'un peu moins de 5 millions de watts (5 Mega Watts ou 5MW), soit une moyenne de 3,6 millions de kilowattheures par mois (3,6MkW/h/m)" (Jeff Gary, "Titan s'avère plus économe en énergie que son prédécesseur“, ORNL(20 août 2014). La consommation énergétique de pointe prévue pour Summit est de 15 MW. Sunway TaihuLight consommerait 15,37 MW (liste Top500, Sunway TaihuLight). L'efficacité énergétique de Titan est de 2 143 GFlops/watts et se classe en 105e position, tandis que l'efficacité énergétique de Sunwai TaihuLight est de 6 051 GFlops/watts et se classe en 20e position (Le Green500, novembre 2017).

Le calcul de Titan s'approche de l'exascale, soit un million de trillions de calculs par seconde (Titan), tandis que le sommet devrait permettre d'obtenir "des performances d'un niveau exquis pour les problèmes d'apprentissage profond - l'équivalent d'un milliard de milliards de calculs par seconde", améliorant ainsi considérablement les capacités du MENNDL, tandis que de nouvelles approches de l'IA deviendront possibles (Hines, Ibid.).

La nécessité et l'utilisation d'une immense puissance de calcul liée à la nouvelle quête réussie de création d'IA avec l'IA est encore plus évidente lorsqu'on regarde le MENNDL ORNL. En attendant, les possibilités que la puissance de calcul et la création d'IA offrent ensemble sont immenses.

À ce stade, nous nous demandons comment la Chine notamment, mais aussi d'autres pays ayant déclaré leur intention de promouvoir fortement l'IA en général, la gouvernance de l'IA en particulier, tels que les E.A.U. (voir Stratégie AI 2031 des E.A.U. - vidéo) se portent bien en termes d'IA capables de créer des IA. Les petits pays peuvent-ils rivaliser avec les États-Unis et la Chine en termes de puissance de calcul ? Qu'est-ce que cela signifie pour leur stratégie en matière d'IA ?

Avec ces deux cas, nous avons identifié la nécessité d'ajouter un autre type de DL, les algorithmes évolutifs, aux deux sur lesquels nous nous sommes concentrés jusqu'à présent, c'est-à-dire l'apprentissage supervisé et l'apprentissage de renforcement. Nous avons également commencé à délimiter les éléments fondamentaux de la puissance de calcul tels que les types d'unités de traitement, le temps, le nombre de calculs par seconde et la consommation d'énergie. Nous approfondirons ensuite notre compréhension de ces éléments en relation avec l'IA.

Enfin, en ce qui concerne ces nouveaux systèmes d'IA, nous devons souligner que leur activité même, c'est-à-dire leur création, est l'un des éléments que les êtres humains craignent de l'IA (voir Présentation de l'AI). En effet, le pouvoir créatif n'est généralement dévolu qu'à Dieu(s) et aux êtres vivants. Elle peut également être considérée comme un moyen pour l'IA de se reproduire. Cette crainte que nous avons identifiée était censée être principalement liée à l'intelligence générale artificielle (AGI) - un objectif probablement lointain selon les scientifiques - et non à l'IA étroite, dont DL fait partie (Ibid.). Pourtant, compte tenu de la nouvelle puissance créatrice de DL qui se libère, nous pouvons maintenant nous demander si nous ne sommes pas un peu plus près de l'AGI. Cela signifierait également que la puissance de calcul (ainsi que, bien sûr, les algorithmes, puisque les deux évoluent ensemble) n'est pas seulement un moteur pour DL et l'AI étroite, mais aussi pour l'AGI.

Image en vedette : Graphique concernant Summit, le nouveau supercalculateur du Oak Ridge National Laboratory du ministère de l'énergie (DOE). L'image a été recadrée et fusionnée avec une autre, de Laboratoire national d'Oak Ridge Flickr, Attribution 2.0 Générique (CC BY 2.0).