2018年可能是美国凭借世界上最强大的超级计算机夺回对中国的领先地位的一年。 这可能是人工智能对计算能力的战争开始的一年。

2017年是人工智能开始创造人工智能(AI)的一年。这一年,中国在排名靠前的超级计算机总数量和总计算性能方面超过了美国。

所有这些事件 正在深深地塑造着我们的未来......和我们的现在。 他们正在重塑战争的方式,同时战略和国家安全的范围也得到了极大的扩展。 他们 是密切相关的。 了解原因和方式对于预见可能发生和已经发生的事情,以及揣摩新兴的人工智能世界将是什么样子至关重要。

这篇文章和后面的文章,使用具体的例子和案例,将解释人工智能和计算能力是如何以及为什么相关的。因此,在深度学习(DL)的人工智能子领域,他们将专注于硬件和计算能力作为人工智能发展的驱动力、力量和利益。此前,我们将计算能力确定为六大驱动力之一,这些驱动力不仅是人工智能扩张背后的力量,也因此成为人工智能力量竞争中的利害关系(Helene Lavoix," ")。人工智能--力量、驱动力和赌注" The Red Team Analysis Society,2018年3月26日)。 我们详细研究了第一个司机与"大数据,人工智能的驱动力......但不是在未来?" (Helene Lavoix, The Red Team Analysis Society, 2018年4月16日)

在这里,我们将从最新的--也是最引人注目的--案例开始,例证硬件及其计算能力与当前人工智能的指数式发展,或者更确切地说,DL的扩张之间存在的紧密关系。计算能力和AI-DL实际上是共同发展的。我们介绍了两个人工智能-DL创造神经网路架构从而实现DL的案例。谷歌的AutoML项目,以及它在计算机视觉应用方面的影响,还有美国能源部橡树岭国家实验室(ORNL)的MENNDL(深度学习的多节点进化神经网络),并将它们与所需的计算能力联系起来。因此,我们开始确定AI-DL所需计算能力的关键要素,强调进化算法的潜力,以及指出我们现在可能离人工通用智能更近一步。

我们将在接下来的文章中更深入地挖掘这种共同进化,更好地理解DL和计算能力/硬件是如何以及为什么相关的。我们将更详细地研究这种关系的影响以及它在硬件方面的共同演变。因此,我们将概述快速发展的游戏状态,并确定需要监测的进一步领域。同时,我们将尽可能地解释从TFLOPS到CPU、NPU或TPU的技术术语,这些术语对于非人工智能和非IT科学家和专家来说无法立即理解,然而,现在需要被政治和地缘政治分析家和相关人士理解。这一深入研究将使我们能够更好地理解正在创建的新人工智能世界中出现的相应动态。

事实上,我们将解释美国对中国电信公司中兴通讯的七年禁令以及其他相关的美国行动必须被理解为是人工智能力量竞赛的一部分的战略举措--即在正在形成的新的国际权力分配中的相对权力地位的竞赛--并且看起来越来越像人工智能至上战争的第一场战斗,正如美国对中国华为的收紧行动所暗示的那样(例如李涛、陈思敏、边佩雷兹,"中兴通讯可能大到不能再大,因为它仍然是中国全球科技野心中楔子的一角“, 南华早报,2018年4月21日;许桂清,"独家 - 美国考虑加强对中国与美国企业的联系的控制“, 路透社。 2018年4月27日).

正如我们所预见的,人工智能已经开始重新划分地缘政治和国际世界(见"人工智能和深度学习--正在形成的新人工智能世界" 和"人工智能何时为地缘政治提供动力--介绍人工智能").

开始设想人工智能创造人工智能

谷歌的 AutoML、NASNet 和阿米巴网的诞生

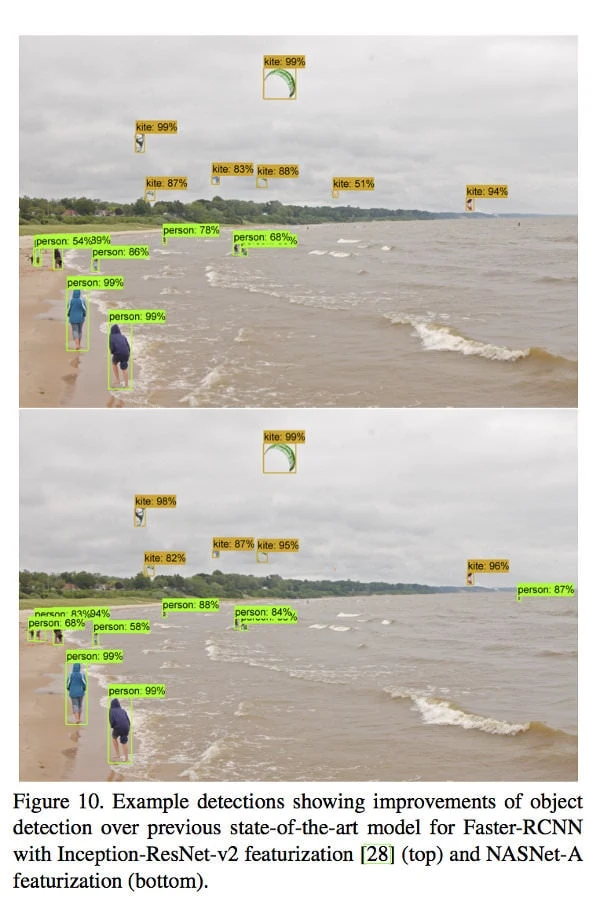

在2017年5月。 谷歌大脑团队 - 谷歌研究实验室之一--宣布它推出了名为AutoML的 "方法",旨在 "探索机器学习模型自动化设计的方法",主要使用进化算法和强化学习(RL)算法,即DL的一个方面,因此也是AI(Quoc Le & Barret Zoph, "使用机器学习来探索神经网络架构“, 谷歌研究博客, 2017年5月17日)。他们首先成功地将该方法用于图像识别和语言建模,但数据集很小。"我们的方法可以设计出与机器学习专家(包括我们自己团队中的一些专家!)设计的最先进的模型相媲美的模型。"(同上)然后,他们在大型数据集上测试了AutoML,"如 图像网 图像分类和COCO物体检测"(Barret Zoph、Vijay Vasudevan、Jonathon Shlens和Quoc Le,"用于大规模图像分类和物体检测的AutoML, 谷歌研究博客, 2017年11月2日)。因此,NASNet应运而生,有不同的规模,对于图像识别来说,它比其他架构取得了更高的准确性和更低的计算成本(见谷歌右侧的图)。例如,"大型NASNet实现了最先进的准确性,而计算成本只有arxiv.org上报道的最佳结果(即SENet)的一半"。[5] 物体检测的结果也比其他架构的好(同上)。

正如谷歌的科学家所指出的,NASNet因此可能极大地改善计算机视觉应用(同上)。考虑到计算机视觉对机器人技术的重要性,特别是对致命性自主武器系统(LAWS)的重要性,能够使用NASNet和NASNet类型的架构,甚至更多的创造更好的程序可能变得至关重要。谷歌 "开源了NASNet,用于图像分类推理和物体检测"(同上),这应该会限制--考虑到还需要使用谷歌的平台,在一定程度上限制了 TensorFlow 机器学习框架,以及美国和中国之间关于人工智能的战争的开始(即将到来)--一个行为者可能使用NASNet而不是另一个。这个例子表明,能够开发和运行 "创造人工智能的人工智能",这比人类设计的人工智能架构更好,这可能被证明对开始的人工智能力量竞赛至关重要,包括在未来可能的战争方面,以及人工智能治理方面。

GPU 是图形处理器。它于 1999 年由 NVIDIA 推出,被认为是 DL 起飞的关键部件。

CPU是一个中央处理单元。在GPU的出现和DL-AI的扩展之前,这是很正常的事情。

两种微处理器都采用不同的架构,具有不同的目标和功能,例如,Kevin Krewell,"CPU和GPU之间有什么区别?"NVIDIA博客,2009年。

如果产生的人工智能架构比人类设计的架构有 "更少的计算成本",那么创造人工智能所需的计算能力是什么?根据谷歌科学家的说法,"最初的架构搜索[用于AutoML]在28天内使用了800个GPU,导致22400个GPU小时。本文中的方法[NASNet]在4天内使用了500个GPU,产生了2,000个GPU小时。前者的努力使用了 英伟达K40 而目前的工作是使用更快的 英伟达P100s.如果不考虑我们使用了更快的硬件,我们估计当前程序的效率大约提高了 7 倍(Barret Zoph、Vijay Vasudevan、Jonathon Shlens、Quoc V. Le,"为可扩展的图像识别学习可转移的架构",2017 年 7 月 21 日提交(v1),2018 年 4 月 11 日最后修订(本版本,v4)、 arXiv:1707.07012v4 [cs.CV] ).

谷歌大脑团队继续其AutoML的努力,寻找开发创造人工智能的最佳方式。在一项比较使用RL和进化的架构搜索的相对优点的实验中,诞生了进化算法,以自动发现图像分类器 阿米巴网: "这是进化算法首次产生最先进的图像分类器"(Esteban Real、Alok Aggarwal、Yanping Huang、Quoc V Le,"图像分类器结构搜索的正则化进化",2018年2月5日提交(v1),2018年3月1日最后修订(本版本,v3)arXiv:1802.01548v3 [cs.NE])。

TPU是张量处理单元,是谷歌为人工智能目的创建的特定应用集成电路,于2016年5月推出。

然而,正如科学家们所指出的,"所有这些实验都需要大量的计算--我们连续几天使用了数百个GPU/TPU" (埃斯特班-雷亚尔,"使用进化的AutoML来发现神经网络架构“, 谷歌研究博客,2018年3月15日). 专门的进化实验 "在900个TPUv2芯片上运行了5天,总共训练了27k个模型",而每个大规模实验 "在450个GPU上运行了大约7天"(Real等人,同上,第12和3页)。

因此,在这种新的搜索中,计算能力对于DL系统创造其他DL系统或AI系统创造AI是至关重要的。如果得到的结果可以再降低计算成本,那只是因为,最初有强大的硬件。然而,无论谷歌致力于AutoML的计算能力有多大,它都不能--还不能?- 与超级计算机可能发生的情况相提并论。

快速人工智能创建器......但只能使用超级计算机

MENNDL - 用于深度学习的多节点进化神经网络

2017年11月28日,美国能源部橡树岭国家实验室(ORNL)的科学家宣布,他们已经开发出一种进化算法,"能够生成定制的神经网络"--即以深度学习为名的人工智能(AI)系统--"其性能与手工制作的人工智能系统相匹配或超过",用于将AI应用于科学问题(Jonathan Hines for ORNL, "为科学扩大深度学习的规模",ORNL,2017年11月28日)。这些新的人工智能系统是在几个小时内产生的,而不是像人类那样在几个月内产生(同上),也不是像谷歌那样在几天和几周内实现。

FLOPS指的是每秒钟的浮点运算。

它是计算机性能的一个衡量标准。太拉FLOPS(TFLOPS)表示一百万百万(1012)每秒的浮点运算。

一个petaFLOPS(PFLOPS)代表1000个teraFLOPS(TFLOPS)。

然而,这一壮举之所以能够实现,是因为MENNDL(用于深度学习的多节点进化神经网络)--这种进化算法 "旨在为独特的数据集评估、进化和优化神经网络"--被用于ORNL的泰坦计算机,一个Cray XK7系统。这台超级计算机是2012年世界上最强大的计算机(2017年11月,Top500名单).2017年11月,它 "只 "排在第五位,但仍然是美国最大的计算机(同上)。"它的17.59 petaflops主要是其NVIDIA K20x GPU加速器的结果"(同上)。

现在,ORNL 应该会得到一台新的超级计算机,它应该会在 2018 年底上线,这就是 "200 petaflops IBM AC922 超级计算机"--Summit(凯蒂-伊莱斯-琼斯"峰会的面孔。准备启动",ORNL,2018年5月1日)。"Summit将提供泰坦18,688个节点的五倍以上[五到十倍]的计算性能,当它在2018年到达时,只使用大约4600个节点。"(峰会 和 峰会常见问题). 每个Summit节点主要由 "两个IBM Power9 CPU、六个英伟达V100 GPU "组成(峰会常见问题).这意味着我们拥有 9200 个 IBM Power9 CPU 和 27600 个 NVIDIA V100 GPU 的计算能力。为了便于比较,泰坦拥有 299 008 个 CPU Opteron 内核和 18 688 个 K20X Keplers GPU,即每个节点有 16 个 CPU 和 1 个 GPU (泰坦,ORNL)。

相比之下,中国--以及世界上--最强大的计算机,"双威太湖之光由中国国家并行计算机工程技术研究中心(NRCPC)开发,并安装在无锡国家超级计算中心的系统 "提供了93.01 petaflops的性能(2017年11月,Top500名单).它使用 10,649,600 个神威-64 CPU 内核(Jack Dongarra、 "关于双威太湖之光系统的报告"。 www.netlib.org, 2016年6月。14).

在能源方面,"泰坦展示了一个典型的瞬时消耗量,略低于500万瓦特(5Mega Watts或5MW),或每月平均360万千瓦时(3.6MkW/h/m)"(Jeff Gary,"事实证明,泰坦号比其前辈更节能“, ORNL,2014 年 8 月 20 日)。预计峰会的峰值能耗为 15MW。新威太湖之光的能耗为 15.37 兆瓦(Top500 榜单、 双威太湖之光).Titan 的功率效率为 2 143 GFlops/瓦特,排名第 105 位,而 Sunwai TaihuLight 的功率效率为 6 051 GFlops/瓦特,排名第 20 位(......)。绿色500, 2017年11月)。

泰坦的计算接近exascale,即每秒100万亿次的计算(泰坦),而Summit应该为 "深度学习问题提供ascale级别的性能--相当于每秒10亿次的计算",大大改善MENNDL的能力,同时人工智能的新方法将成为可能(Hines,同上)。

当看到ORNL MENNDL时,与用人工智能创造AI的新的成功探索有关的巨大计算能力的需求和使用就更加清晰了。同时,计算能力和创造人工智能一起产生的可能性是巨大的。

在这一阶段,我们想知道中国是如何做到的,同时也想知道其他国家是如何表示要大力推动人工智能,特别是人工智能治理的,比如阿联酋(见 阿拉伯联合酋长国2031年人工智能战略 - 视频)在能够创造AI的AI方面的表现。较小的国家是否可以在计算能力方面与美国和中国竞争?这对他们的人工智能战略意味着什么?

通过这两个案例,我们发现我们需要在迄今为止我们所关注的两种类型的DL,即监督学习和强化学习之外,增加另一种类型的进化算法。我们也已经开始划定基本的计算能力要素,如处理单元的类型、时间、每秒钟的计算次数和能源消耗。接下来我们将进一步详述我们对这些与人工智能有关的理解。

最后,考虑到这些新的人工智能系统,我们必须指出,它们的活动本身,即创造,是人类对人工智能恐惧的因素之一(见 介绍人工智能).事实上,创造能力通常只归于上帝和生物体。这也可能被看作是人工智能繁殖的一种方式。我们确定的这种恐惧主要是指人工通用智能(AGI)--根据科学家的说法,这可能是一个遥远的目标--而不是狭义人工智能,DL是其中的一部分(同上)。然而,考虑到DL正在释放的新的创造性力量,我们现在可能会想,我们是不是离AGI更近了一步。反过来,这也意味着计算能力(当然还有算法,因为两者共同发展)不仅是DL和狭义人工智能的动力,也是AGI的动力。

特色图片。关于能源部(DOE)橡树岭国家实验室新的超级计算机峰会的图片。图片经过裁剪并与另一张图片合并,来自 橡树岭国家实验室Flickr, 署名 2.0 通用版 (CC BY 2.0)。